大数据文摘微信公众号(ID:BigDataDigest) 作者:宁云州、魏子敏、Aileen

星际II的玩家们,你们准备好迎接被AI支配的恐惧了吗?!

用阿尔法狗征服了围棋界的DeepMind正把目光投向游戏界:昨日凌晨,DeepMind官网发布消息,已正式与暴雪娱乐合作,共同开发可以在星际争霸II中与人类玩家对抗的AI,并且发布了SC2LE,一个旨在加速即时战略游戏当中AI应用的工具集。

早在去年,Deepmind已经立下Flag要教会AI玩儿星际争霸II,也已经有包括facebook、阿里巴巴等不少科技公司或者研究机构开拓过“星际”这片竞技场,但DeepMind这样专治人类各种不服的公司正式宣布与暴雪合作,还是让一票星际玩家大呼“热血”。 暴雪承诺将持续发布从“星际争霸II”天梯中收集的数十万个匿名录像,这会将训练变得更加容易。 当然,这也不是一项轻松的任务:视频游戏的复杂性和更多可能性也让AI战胜人类要远比在棋盘游戏上复杂。

但是不可否认,不管对于星际玩家圈还是AI圈来说,这都是一件大事情,因为星际争霸远比像围棋这样的游戏更接近现实世界。

搞定星际争霸可能需要十只升级版阿尔法狗

星际争霸和星际争霸II是史上最大和最成功的游戏之一,它们见证了许多玩家从青葱岁月到为人父母的20多年。其原始游戏早已被AI和ML研究人员使用,并在每年的AIIDE机器人大赛中进行角逐。

昨日凌晨,DeepMind宣布与暴雪娱乐合作,发布了SC2LE,一个旨在加速即时战略游戏当中AI应用的工具集,SC2LE包括:

暴雪开发的一种可以让研究人员和开发人员投入到游戏中的机器学习API,这包括第一次为Linux发布的工具。

一个匿名的比赛录像数据集,这将使得比赛录像的数据集从原来的65,000增加到超过50万。

一个开放源码的版本的DeepMind的工具,PySC2,让研究人员能够方便地使用暴雪的特征层API和他们的代理。

一系列简单的RL小游戏,允许研究人员测试代理在特定任务上的表现。

联合文件,用以概述环境,报告迷你游戏的基本结果,根据游戏回放监督学习,和使用AI与人类进行完整的1v1对战。

使用AI在星际争霸中对战人类玩家会比围棋艰难得多,对于AI来说,最大的难点在于,每一场对决都存在大量可能的方式。

据估计,每场对决有101685种可能的配置,为了给大家一个直观感受,阿尔法狗的配置层是10170。

此外,不同于棋类游戏的轮流依次进行走步,并且拥有决策的时间,在星际争霸中,玩家会同时出招,且不能看到对方玩家的状态,也就是说,所有决定需要在“不完整信息”的情况下做出。所有这些都意味着,你不能仅靠逻辑和一些步骤找到赢得对决的最优方式,玩家更需要的是策略和直觉。

DeepMind为什么在围棋之后选择星际争霸

星际争霸拥有丰富多彩的游戏环境和战术体系,这是AI研究的理想环境。

例如,虽然游戏的目标是击败对手,但玩家需要在收集资源或建造建筑等等这些子目标中进行权衡。另外,一场对战的时间可以从几分钟到一个小时不等,这意味着在游戏早期采取的行动可能在很长时间内都不会有回报,如果你使用开局一波的打法,就很可能在进攻受挫后丧失主动权。最后,因为战争迷雾的关系玩家无法拥有全部地图的视野,这意味着AI必须使用记忆和计划的结合才能成功。

星际争霸II还有其他一些吸引研究者的特质,比如大量每天都在网上进行游戏的玩家。这可以确保研究者们可以得到大量的回放数据以供学习,也可以为AI代理提供大量极具天赋的对手。

星际争霸II的玩家在同一时间可能有300多种基本行动可以选择,因此策略集及策略选择也对AI构成了巨大的挑战。与此形成鲜明对比的是雅达利游戏,大概只有10种选择(例如,下,左,右等)。除此之外,星际争霸中的很多操作是分级的,可以进行修改和扩充,其中很多都需要操作屏幕上的一个点进行。即使一个小84X84的屏幕也会产生大约1亿种可能的行动选择。

行动是否对人类和代理都可用取决于选择的单位。

这次发布的PySC2意味着研究人员现在可以利用暴雪自己的工具来解决这些挑战,并且构建自己的任务和模型。

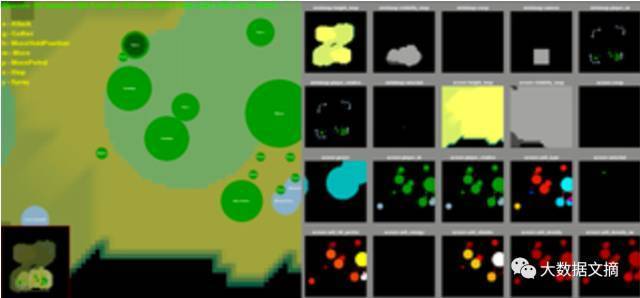

PySC2环境提供了一个灵活的,易于使用的RL代理游戏界面。在最初的版本中,游戏被分解为‘特征层’,其中的游戏元素,如单元类型、单位的健康度和地图的可见性彼此隔离,同时保留游戏的核心视觉和空间元素。

PySC2工具集中的特征层

这次发布的PySC2还包括一系列的迷你游戏,一种将游戏分解成小模块的技术,可以用来测试特定任务的代理,比如移动视角、收集矿物碎片或选择单位。DeepMind希望研究人员可以测试他们的技术,并且开发新的迷你游戏,以供其他研究人员进行使用和评估。

简单的RL迷你游戏可以让研究者测试代理在一些特定任务上的表现

从十万匿名录像中向顶级人类玩家吸取经验

为了让DeepMind的代理学习更强大的策略,需要使用模仿学习技术。 暴雪承诺将持续发布从“星际争霸II”天梯中收集的数十万个匿名录像,这会将训练变得更加容易。 这不仅可以让研究人员训练可监督的代理来进行游戏,还可以打开其他有趣的研究领域,如序列预测和长期记忆。

现在,丹麦哥本哈根IT大学的Sebastian Risi和他的同事Niels Justesen已经开始将AlphaGo应用于“星际争霸”。 到目前为止,他们已经从有世界上最好的人类星际争霸玩家参与的超过2000场比赛中提取了大约630000场录像,训练了他们的AI,让它慢慢地学会预测一个顶级的人类玩家在某些特定的游戏状态下会做什么,这样当面对类似的选择时,它可以做出顶级玩家会做的判断。

目前,Risi和Justesen的成果仍可以被其他“星际争霸”的机器玩家打败。 然而,那些机器的方法是把人类战略硬编码进系统,这意味着一旦有人类对手在战略中发现了一个漏洞,他们就能够从那里轻松地击败他们,这样的机器是不具备和人类正面对决的能力的。

这意味着,破解“星际争霸”甚至可以使AI通用地进步,因为玩好这款游戏需要考虑存储,策略和操作并且规划这一系列复杂的组合。 DeepMind的Oriol Vinyals说:“这款游戏是一座通往现实世界的桥梁。”

在星际争霸2的世界顶级赛事中,人类玩家在比赛中奇诡的战术和精湛的操作,往往使我们感叹于玩家技术水平的高超,而如果AI能够像在围棋比赛中击败柯洁那样在星际争霸2这类对操作、策略和运营的要求都达到极限的游戏中击败人类的顶尖选手,我们还有兴趣打开电脑在鼠标高频率的敲击声中日复一日地攀爬天梯吗?

相信即便面对来势凶猛的末日人机,还是会有无数的玩家像泽叔一样喊出那声“为了艾尔而战!”