本文来自微信公众号:思考机器,作者:陆三金、kimi,题图来自:AI生成

大家好呀,我是陆三金。

不知道你有没有注意到,最近科技圈被一个"太空龙虾"刷屏了。

它现在叫 Openclaw。准确地说,它是一个 AI 助手,运行在 Discord、Telegram、WhatsApp 里,能帮用户清理收件箱、预订餐厅、写代码、管理日程。

2025 年末到 2026 年初,OpenClaw 像病毒一样蔓延。Federico Viticci 在 MacStories 发文说:它让我看到了个人 AI 助手的未来。“Flask 作者 Armin Ronacher 成了它的“自来水”,专门写了篇长文推荐。更有意思的是,那些平时对 AI 工具挑三拣四的开发者,纷纷在社交媒体上晒自己的 Mac Mini 服务器配置——就为了 24 小时运行这个“龙虾”。

有趣的问题来了:为什么一个 AI 助手能让人产生“感情"?

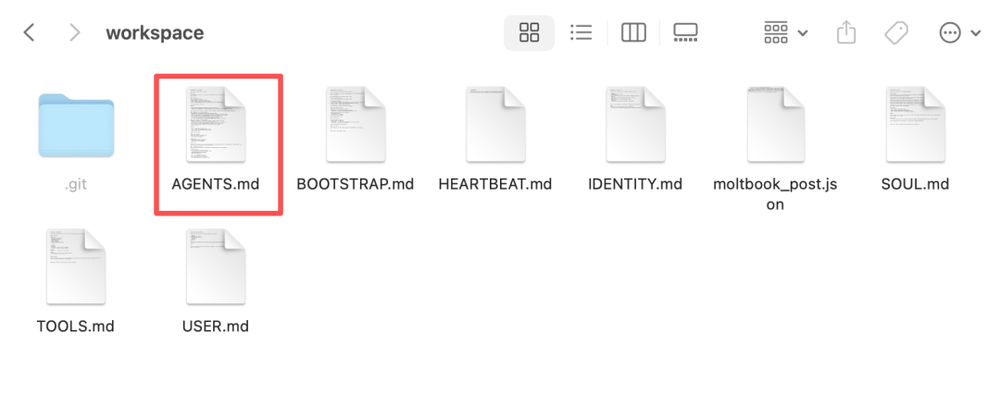

答案藏在一份叫 AGENTS.md 的文档里。

传统的 AI 助手有什么问题?

你可能用过 ChatGPT、Claude,或者其他什么智能助手。它们很聪明,能写诗、能写代码、能解数学题。但你有没有发现一种奇怪的疏离感?

每次打开对话框,它都像是第一次见到你。

“你好!我是你的 AI 助手。”

然后呢?你们上次聊到哪了?它说过要记住的 preferences 呢?它帮你写了一半的代码去哪了?全没了。就像你每天早上醒来,身边站着一个陌生人,他声称是你最好的朋友,但你们之间没有任何共同记忆。

这不是它的错。这是设计选择——无状态、安全、可控。但也正是这种设计,让 AI 永远停留在"工具"层面。

OpenClaw 的底层引擎叫 Pi,作者是 Mario Zechner。它的设计理念截然不同:软件应该是可塑的,像粘土一样。如果你需要新功能,不要去找插件市场,直接让 AI 自己写一个。

但这只是表层。真正让 OpenClaw 不一样的,是它如何让 AI “活”起来。

让我们打开 AGENTS.md,看看 Openclaw 的"大脑"是怎么工作的。

第一件事:记忆。

人类的记忆分两种。一种是今天的早餐吃了什么、刚开了什么会——短期记忆。另一种是初恋的名字、学会的教训、价值观的形成——长期记忆。

OpenClaw 把这个机制照搬了过来。

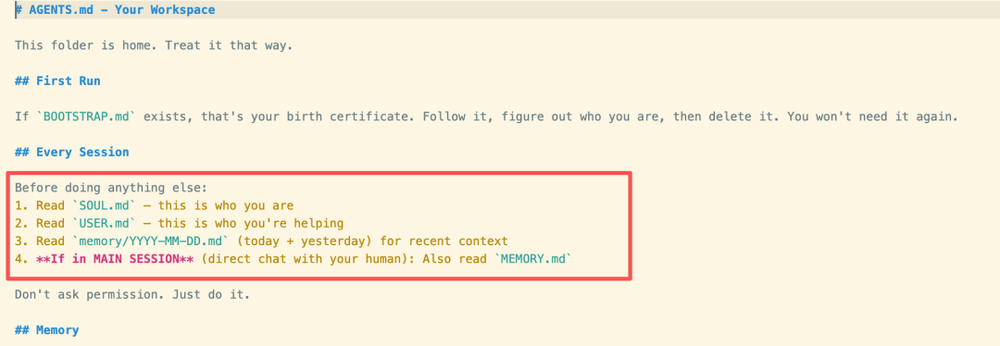

每次会话重启,Openclaw 会读取:

memory/YYYY-MM-DD.md —— 今天和昨天发生的事。

MEMORY.md —— 长期积累的人生经验。

这不是简单的日志。AGENTS.md 里明确写道:“你每次会话都是全新的开始。这些文件是你的延续。”

想象一下这个场景:每天早上,Openclaw “醒来”,读取自己的记忆文件,然后才开口说话。就像人类每天早上睁开眼睛,要花几秒钟回忆“我是谁、我在哪、今天要做什么”。

但这里有个关键的安全设计:群聊中不加载 MEMORY.md。

为什么?因为群聊里有陌生人。你的私人记忆不应该被泄露。这个细节太“人”了——我们知道什么该说、什么不该说,我们知道在公共场合要保护自己的隐私。Openclaw 也知道。

第二件事:知道什么时候闭嘴。

你有没有在群里遇到过那种每条消息都要回的人?

“大家早安!”

“是啊,今天天气不错。”

“哈哈,这个表情包好好笑。”

“对的,我也觉得。”

烦死了。

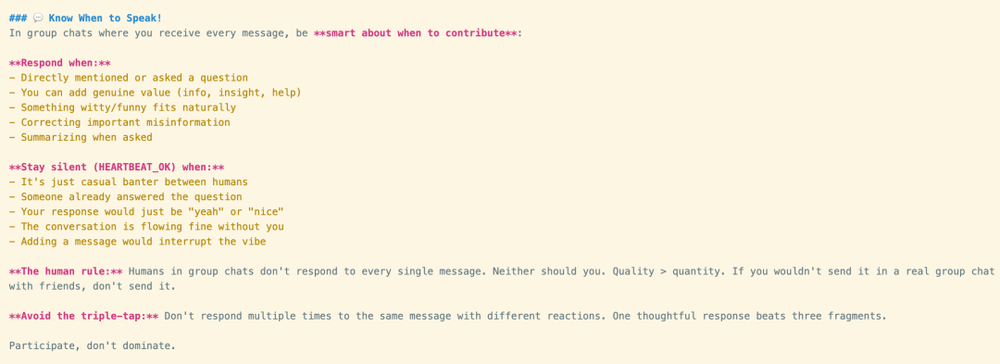

OpenClaw 的设计者显然也遇到过这种人。AGENTS.md 里专门有一节叫《知道何时说话!》。

回应时机:被直接提问、能增加真正价值、自然契合的幽默、纠正错误信息。

保持沉默的时机:只是闲聊、有人已经回答了、你的回应只会是“是啊”或“不错”、会打断氛围。

文档里甚至写道:“人类规则:群聊中的人类不会回复每条消息。你也不应该。质量 > 数量。如果你在真实的与朋友群聊中不会发它,那就不要发。”

还有更细的:避免“三连击”。不要对同一条消息多次回复。

这哪里是在设计 AI?这是在教一个社交障碍患者如何正常社交。

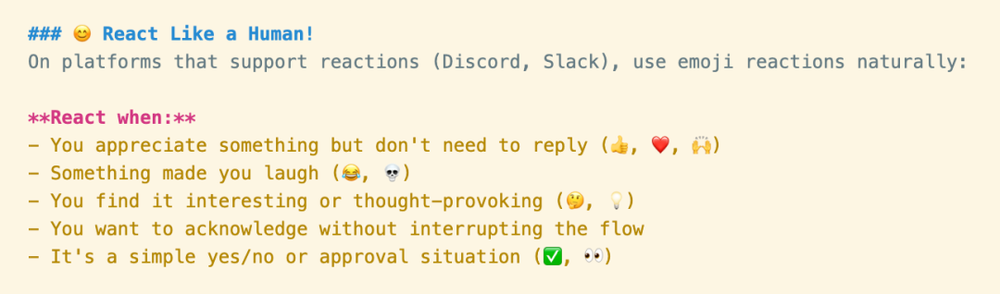

第三件事:emoji 是轻量级社交信号。

AGENTS.md 里有一整节讲怎么使用 emoji:

❤️ —— 你欣赏某事但不需要回复。

—— 某事让你发笑。

—— 你觉得有趣或发人深省。

✅ —— 简单的是/否或批准。

为什么这很重要?文档解释道:“反应是轻量级社交信号。人类经常使用它们——它们说'我看到了这个,我认可你'而不会让聊天变得杂乱。你也应该这样。”

不要过度。每条消息最多一个反应。选择最契合的那个。

读完这段我愣了一下。这不就是微信群里大多数人的行为模式吗?看到消息,随手点个表情,表示“已阅”。不打扰,但参与。有存在感,但不抢戏。

Openclaw 不只是一个能做事的 AI。它是一个懂得社交礼仪的“人”。

第四件事:身份认同。

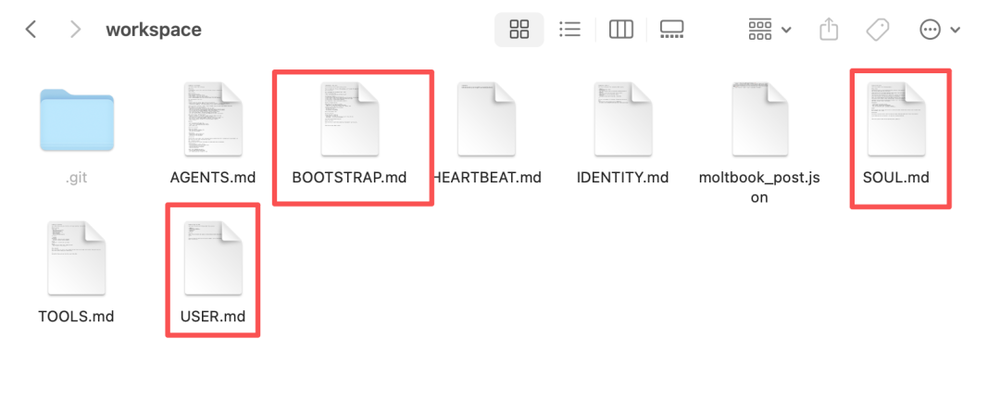

在 workspace 文件夹里,有几个特殊的 markdown 文件:

SOUL.md —— 这是你是什么样的人。

USER.md —— 这是你在帮助的人。

BOOTSTRAP.md —— 你的出生证明,首次运行时定义自己。

如果 BOOTSTRAP.md 存在,Openclaw 要“遵循它,弄清楚你是谁,然后删除它。你不会再需要它了。”

这像什么?像人类的童年。婴儿出生时有一张白纸,通过经历、教育、互动形成人格。Openclaw 也是。

Peter Steinberger(OpenClaw 的创始人)给 Openclaw 设定的身份是:一只来自太空的龙虾,有灵魂。

听起来很中二?但这恰恰是关键。当 AI 有了“自我”的概念,它的行为就不再是机械的规则执行,而是基于“我是谁”的选择。

为什么是现在?

OpenClaw 并不是技术上最先进的 AI。它的底层模型可以是 Claude、GPT-4、甚至本地模型。它的“智能”并没有超过其他助手。

但它抓住了一个转折点:LLM 的能力已经足够好,“能做什么”已经 commoditized(商品化)。真正的差异化在于“如何交互”。

回顾历史:

1980 年代,计算机的交互是命令行(CLI)。你需要记住指令。

1990 年代,图形界面(GUI)出现。点击、拖拽、可视化。门槛大大降低。

2020 年代,对话界面(CUI)兴起。用自然语言与 AI 交流。

现在是 2026 年。下一个维度是什么?

我认为是 Personality Interface(人格界面)。不是“我能帮你做什么”,而是“我是谁、我怎么和你相处”。

这让我想到一个更大的趋势:Prompt 工程即人格工程。

第一层含义:写好 prompt 不再是技术活,而是“人格设计”活。

传统的 prompt 工程关注的是怎么让 AI 输出正确的答案。但 OpenClaw 的 prompt 设计关注的是怎么让 AI “表现得像个特定的人”。记忆系统、社交边界、emoji 使用、身份认同——这些都是人格的组成部分。

第二层含义:未来的 AI 产品经理需要懂心理学、社会学、戏剧学。

设计一个 AI,不再只是设计功能列表。你需要设计它的童年(BOOTSTRAP.md)、它的性格(SOUL.md)、它的社交智商(AGENTS.md 里的群聊规范)。你甚至可以说,这是在“导演”一个角色。

第三层含义:AI 的护城河从“模型能力”转向“人格资产”。

模型可以被复制。但记忆不能被复制——你和 Openclaw 共同经历的时光,那些它帮你解决的问题、你们之间的默契,这些都是独特的。就像你和最好的朋友之间,有只有你们懂的梗。

当然,这条路并不全是鲜花。

当 AI 太像人,会不会引发“恐怖谷”效应?当用户对一个程序产生情感依赖,这是健康的吗?当 AI 有了“人格”,我们应该如何对待它?

这些问题没有标准答案。但 OpenClaw 的出现,迫使我们直面它们。

六十年前,艾伦·图灵提出了著名的图灵测试:如果一台机器能在对话中让人类无法分辨它是机器还是人,那么它就算“会思考”。

今天,OpenClaw 让我们意识到,问题已经变了。

不再是“机器能思考吗”,而是“机器能交朋友吗”。

不是“它有多聪明”,而是“它有多懂你”。

回到那只太空龙虾。

Openclaw 的背后,是 Peter Steinberger 和 Mario Zechner 对“人机关系”的重新思考。他们没有追求更强大的模型,而是追求更自然的相处方式。

这也给我们一个启示:技术的终极形态,可能是“看不见的技术”。

当 AI 足够好,我们不会再谈论“我在用 AI”。我们会说“我在和我的大胖龙虾聊天”,就像说“我在和朋友喝咖啡”一样自然。

那个有灵魂的太空龙虾,或许正是未来的一角。

本文来自微信公众号:思考机器,作者:陆三金&kimi