上周商汤的最新刚靠软银融资的新闻,给国内的AI创业公司们重新找回了点“关注度”。但就在前几天早上,引领AI走向现实世界的英伟达又发布新产品了,这对于很多喊着要做芯片的AI创业公司都是一个最坏的消息。

原因很简单,在本周四举办的GTC(GPU技术峰会)2018的日本站上英伟达公布了全新一代的云端高效率版“AI推断加速器”——NVIDIA TESLA T4。

TESLA T4有多强?

先来说说TESLA T4的定位,它实际是一款云端专用的GPU加速卡,个头很小(半高PCIE卡),但是性能很强。

根据英伟达官方公布的数字:它的单浮点(FP32)运算能力能达到8.1TFLOPs,混合精度运算能力能够达到65 FP16 TFLOPs,INT8精度运算能力能够达到130TOPs,INT4精度运算能力能够达到260TOPs。同时,据传英伟达也将在这款产品上尝试全新的INT1运算模式,根据INT4运算能力推算,INT1的运算能力可能会达到史无前例的1080TOPs。

尽性能如此强劲,但TESLA T4真正追求的是整体系统效率而不是绝对性能。

这也符合英伟达“英文字母+4”这一命名规则的历史其他产品(例如M4和P4)。相比单卡更加强劲的TESLA家族其他型号,这几款产品的思路在明显不过——在最高效简洁的供电条件上,搭配最高效的核心配置,从而最终实现全服务器系统最高的工作效率。

以已经被证实在AI图像“推断”处理中更高效的INT8运算能力来说,T4达到了130TOPs,“上一代(Volta架构无该定位产品)”的P4只有区区22TOPs。这意味着,在不到两年的时间里,性能和能效比都增长了6倍。

这个速度是最辉煌时期的“摩尔定律”(18个月翻一倍)都不能比拟的。

性能之外,“4”系列GPU加速卡还有3个必定遵循的设计原则:最高功耗始终不超过PCI-E供电最高的75W;始终采用更加紧凑的半高单卡槽设计(便于密集部署);始终采用无风扇的全被动散热方案。三个原则最终进一步加强了产品的实际效能。

TESLA T4性能如此强劲,不禁让人遐想全能版的T100能力

当然,单个计算单元性能较弱的问题在实际应用中也有所影响,就拿GPU加速卡最常用的AI领域中的“模型训练(通过大量数据和合适的神经网络让计算机学会规律)”来说,更大的计算单元和存储能力(容量、读取速度),几何倍数级优于小的。

但训练不行,AI还需要“推断(根据提前生成的神经网络规律,输出结果)”,这一部分操作并不需要特别大的计算单元和存储能力,而且在一类应用的AI算法、神经网络训练到一定程度的基础上,实际上需要的都是“推断”能力。

你也可以形象的理解为,“训练”是一个不断开荒和优化种植技术的过程,但最终的农田管理和农作物的管理,实际上都是“推断”来负责的。

大华股份的“睿智”系列GPU服务器

以目前AI应用领域“走在最前”的安防领域来说,国内的一众巨头企业,如海康威视、大华等很早都采用了英伟达的技术方案,其中就包括大量安装有TESLA P4的云端处理器。

也有不少AI创业公司,也正在研究进军安防领域的可能性。除了云市场,英伟达还在端市场部署了Jetson系列产品,相信不久的将来“图灵”架构也必然会更新到Jetson平台上,最终对绝大多数、想要造芯片的AI创业公司,形成致命威胁。

NVIDIA正在加速收割AI芯片?

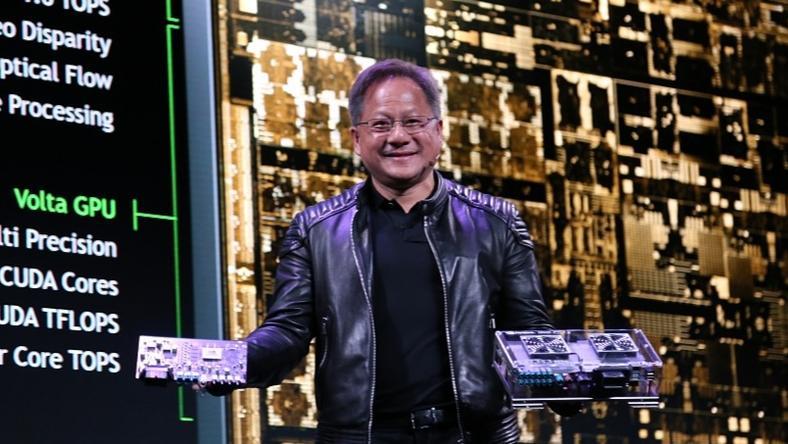

黄仁勋发布新架构“Turing(图灵)”

在很多AI公司的宣传资料、券商、调研机构的报告中,对于AI芯片市场,总会有一句类似这样的判断——英伟达是“AI训练”领域的霸主,相比之下“AI推断”市场还有更多的机会。

但事情真的是这样吗?尤其是在看完TESLA T4之后,你还认为这是个可以信赖的说法吗?

至少我不这样认为,尤其是老黄在SIGGRAPH(计算机图形学会议)上发布了全新的“图灵”架构之后,我们实际上可以关注到一个很重要的趋势——本身偏向通用处理器的GPU,正在愈发“专用化”。

以最新的RTX 2080Ti为例,分别对应AI处理的Tensor Core、对应光线追踪处理的RT Core,总数就达到了612个。这也可以作为英伟达应对“摩尔定律”即将失效的一个手段,既然制程和基础技术无法带来提升,我们就从芯片的架构和效率上寻找空间。

再“巧”不过的是,最近几年GPU终于将幻想了数十年的人工智能变成了现实,并且在多方的共同努力下,愈发开枝散叶。

尽管英伟达自己的确从来没有说过“垄断市场”、“唯我独尊”之类的话语。包括著名的“皮衣教主”,还是一如既往的和蔼可亲。但英伟达的技术研发实力依旧在那里,步伐更是从未停歇,不断向AI界输出全新的理念。

英伟达官方的研究表明,INT8运算模式能够大幅提高AI图像处理的速率

处理速率大幅提升的同时,AI运算结果的差异性基本可以忽略

就例如从TESLA P4 GPU加速卡开始支持的INT8运算,它实际上是一种更低精度的运算方式,但根据英伟达官方自己的研究,在很多应用场景中,这种精度的下降并不会明显影响结果,反而能够让芯片性能倍数上升(相对于精度更高的FP16、FP32)运算。

这种取巧的路线很快也影响了整个业界的认识,于是乎,AI创业公司们也开始在首款或者是下一代产品中加入INT8的运算能力。

可结果是,这头AI创业公司们的“自主芯片”还没有看到什么影子,那头英伟达又更新了,而且还带来了INT4运算能力,同时还支持实验性的INT1运算能力。后两者目前的研究还不深,但相信英伟达不可能“空穴来风”。

一旦证明了INT4乃至INT1工作效率更高,那么很多AI创业公司花了大钱才造出来的芯片和产品,刚出生就已经落后了。

英伟达的平台拓展能力也值得关注,以这次GTC JAPAN为例,英伟达除了发布了全新的TESLA T4 GPU加速器之外,同时还公布了两个全新的开发平台——AGX、Clara。前者对应的是自动机械,后者对应的是医疗应用。

不过英伟达对于这两个领域并不陌生,英伟达的产品实际上也早已经应用到了这两个领域当中,但建立平台这一举动,或许意味着英伟达在2019年把这两个当做主要发展方向了。

总的来看,英伟达这个帮助AI崛起、半导体技术深厚、不断拓展市场的硅谷巨头,正在不断吃下AI市场的红利,这也是公司盈利和创造价值的基础目标所指引的方向。但创业公司真的必须加速了,再不跑快点,那就真的要死在巨头的“脚掌”下了。